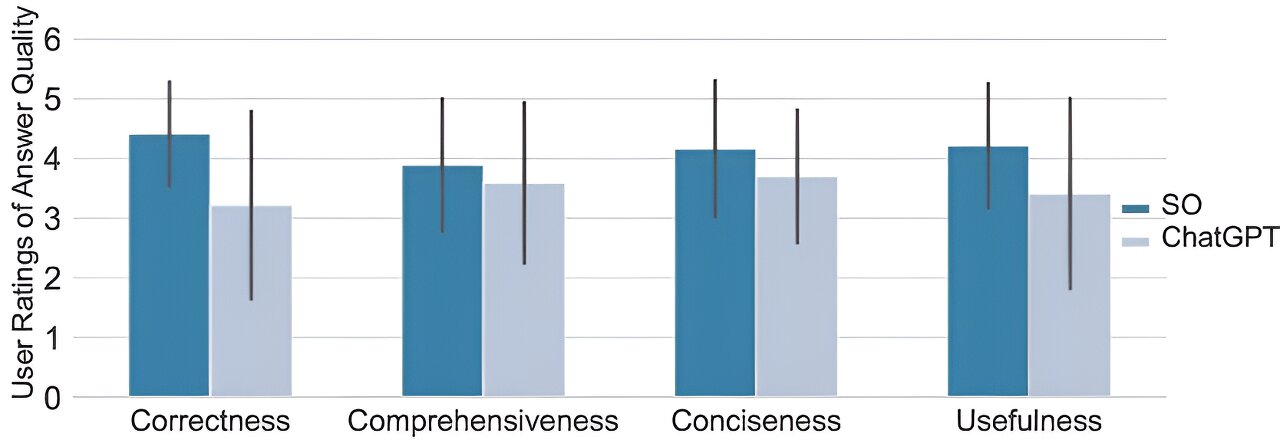

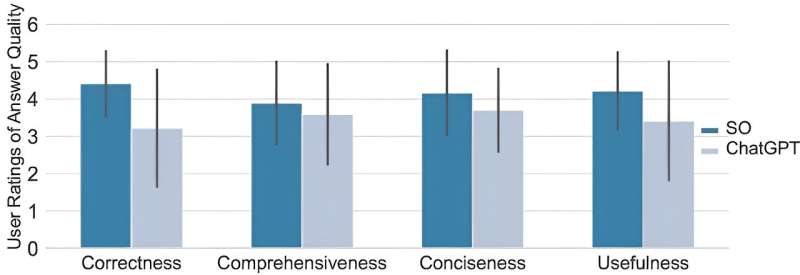

Qualità delle risposte valutata dai partecipanti. credito: Atti della conferenza CHI sui fattori umani nei sistemi informatici (2024). doi: 10.1145/3613904.3642596

Un team di scienziati informatici della Purdue University ha scoperto che il popolare programma LLM ChatGPT è altamente impreciso nel rispondere a domande sulla programmazione del computer. In carta Pubblicato come parte di Atti della conferenza CHI sui fattori umani nei sistemi informaticiIl gruppo descrive come hanno estratto le domande da StackOverflow, le hanno poste su ChatGPT e poi ne hanno misurato l’accuratezza quando hanno risposto.

Il team ha inoltre presentato i risultati alla conferenza Human Factors in Computing Systems (Chi 2024) si è svolto dall’11 al 16 maggio.

ChatGPT e altri software LLM hanno fatto molto parlare di sé ultimamente e, non appena tali applicazioni sono diventate disponibili al grande pubblico, sono diventate molto popolari. Sfortunatamente, oltre al tesoro di informazioni utili incluse in molte delle risposte fornite da queste app, ci sono molte informazioni imprecise. Ciò che è ancora più spiacevole è che non è sempre chiaro quando le app danno risposte sbagliate.

In questo nuovo studio, il team della Purdue ha osservato che molti studenti di programmazione hanno iniziato a utilizzare gli MBA non solo per aiutare a scrivere codice per compiti di programmazione, ma per rispondere a domande relative alla programmazione. Ad esempio, uno studente potrebbe chiedere a ChatGPT, qual è la differenza tra bubble sort e merge sort o, più comunemente, cos’è la ricorsione?

Per scoprire quanto accuratamente MBA possa rispondere a queste domande, il team di ricerca ha concentrato i propri sforzi solo su uno di essi: ChatGPT. Per trovare domande da utilizzare per testare l’app, i ricercatori hanno utilizzato domande disponibili gratuitamente su StackOverflow, un sito creato per aiutare i programmatori a saperne di più sulla programmazione lavorando con altri nel loro campo di interesse. In una parte del sito, gli utenti possono postare domande a cui risponderanno altri che conoscono le risposte.

Il team di ricerca ha utilizzato 517 domande sul sito e poi ha misurato il numero di volte in cui ChatGPT ha fornito la risposta corretta. Sfortunatamente, questo era solo nel 52% dei casi. Hanno anche scoperto che le risposte tendevano ad essere più dettagliate rispetto a quando veniva posta la stessa domanda a un esperto umano.

In modo allarmante, il team ha scoperto che i partecipanti allo studio sugli utenti preferivano le risposte fornite da ChatGPT il 35% delle volte. I ricercatori hanno anche scoperto che gli stessi utenti che leggevano le risposte fornite da ChatGPT più spesso non si accorgevano degli errori commessi, ma piuttosto trascuravano le risposte sbagliate il 39% delle volte.

maggiori informazioni:

Samia Kabir et al., Stack Overflow è obsoleto? Uno studio sperimentale sulle proprietà di ChatGPT risponde alle domande Stack Overflow, Atti della conferenza CHI sui fattori umani nei sistemi informatici (2024). doi: 10.1145/3613904.3642596

© 2024 Web of Science

la citazione: Gli scienziati ritengono che ChatGPT sia impreciso quando rispondono a domande sulla programmazione del computer (27 maggio 2024) Estratto il 27 maggio 2024 da https://techxplore.com/news/2024-05-scientists-chatgpt-inaccurate.html

Questo documento è soggetto a copyright. Nonostante qualsiasi comportamento corretto a scopo di studio o ricerca privata, nessuna parte può essere riprodotta senza autorizzazione scritta. Il contenuto è fornito solo a scopo informativo.

“Internet savvy. TV fan. Infuriatingly humble analyst. Unapologetic Twitter pioneer. Freelance coffee fanatic.”